推荐语

KnowFlow v2.1.9推出知识库导入导出功能,解决企业离线环境算力不足与资源浪费的痛点,实现知识管理无缝衔接。

核心内容:

1. 企业离线环境面临的三大痛点:算力困境、资源浪费、迁移壁垒

2. KnowFlow的解决方案:在线解析+离线使用的高效模式

3. 实际应用场景与数据对比展示功能优势

杨芳贤

53AI创始人/腾讯云(TVP)最具价值专家

前言

在企业级知识管理场景中,一个长期被忽视的痛点正在浮出水面:如何让在线环境的强大算力服务于离线场景?

KnowFlow v2.1.9 重磅推出知识库导入导出功能,帮助企业实现"在线解析、离线使用"的无缝衔接。这不仅是一次功能升级,更是对企业知识管理模式的重新思考。

KnowFlow 是专注于私有化高准确率的企业级知识库产品,将结构化与非结构化数据治理成对大模型更可信的输入,致力于构建 AI 时代的数据根基。

为什么需要知识库导入导出?

痛点一:离线环境的算力困境

在与众多企业客户的交流中,我们发现了一个普遍存在的矛盾:

场景描述:

- • 🏢 金融机构:核心业务系统部署在物理隔离的内网环境

这些企业的共同困境是:

离线环境算力有限 ⚠️

↓

文档解析效率低下 🐌

↓

知识库构建周期长 ⏳

↓

AI 应用落地困难 ❌

痛点二:重复解析的资源浪费

许多企业面临的典型场景:

数据对比:

- • 📄 1000 页 PDF 使用 MinerU 解析:在线环境 5 分钟,离线环境可能需要 30+ 分钟

- • 📚 100 份技术文档全流程处理:在线环境 1 小时,离线环境可能需要一个工作日

- • 💰 GPU 算力成本:在线按需使用,离线需要长期投入

痛点三:知识库迁移的技术壁垒

企业在以下场景中经常遇到迁移难题:

- 1. 多环境部署:开发 → 测试 → 预生产 → 生产,每个环境都要重新处理

解决方案:在线解析 + 离线使用

KnowFlow 的知识库导入导出功能,完美解决了上述痛点:

核心理念

┌─────────────────────────────────────────────────────────┐

│ 在线环境(算力充足) │

│ ┌──────────────────────────────────────────────────┐ │

│ │ 📤 强大算力加持 │ │

│ │ • GPU 加速文档解析 │ │

│ │ • 多引擎并行处理(MinerU/PaddleOCR/DOTS) │ │

│ │ • 智能分块优化 │ │

│ │ • 向量化批量处理 │ │

│ └────────────────┬─────────────────────────────────┘ │

│ │ │

│ │ 一键导出(包含完整元数据) │

│ ▼ │

│ ┌──────────────────┐ │

│ │ 知识库压缩包 │ │

│ │ .knowflow.zip │ │

│ └─────────┬────────┘ │

└───────────────────┼─────────────────────────────────────┘

│

│ 物理介质传输(U盘/专线)

▼

┌─────────────────────────────────────────────────────────┐

│ 离线环境(算力受限) │

│ ┌──────────────────────────────────────────────────┐ │

│ │ 📥 秒级导入,即刻可用 │ │

│ │ • 无需重新解析文档 │ │

│ │ • 无需重新分块 │ │

│ │ • 无需重新向量化 │ │

│ │ • 保留所有元数据和配置 │ │

│ └──────────────────────────────────────────────────┘ │

│ │

│ ✅ 知识库立即可用,开始检索和问答 │

└─────────────────────────────────────────────────────────┘

价值体现

1. 算力成本优化

传统模式:

离线环境:需要配置高性能 GPU 服务器

投入成本:10万+ / 年(硬件 + 电费 + 维护)

使用率:可能只有 20%(文档解析只是偶尔进行)

新模式:

在线环境:按需使用云端 GPU(如阿里云、腾讯云)

解析成本:500元左右可处理 10000+ 页文档

离线环境:只需基础算力,专注检索和问答

综合节省:80% 以上的硬件投入

2. 时间效率提升

3. 业务连续性保障

- • ⚡ 快速部署:新环境 5 分钟内完成知识库部署

- • 🔄 灾备恢复:主备环境快速切换,RTO < 10 分钟

功能详解

一、导出功能

导出内容

一个完整的知识库导出包包含:

kb_export_202501124_140812.zip

│

├── metadata.json # 知识库元数据

│ ├── version # 版本

│ ├── export_time # 导出时间

│ ├── tenant_id # 租户 ID

│ └── knowledgebases/ # 知识库基础信息

│

├── files/ # 原始文件

│ ├── doc_1.pdf

│ ├── doc_2.png

│ └── ...

│

└── chunks.json # 分块元数据

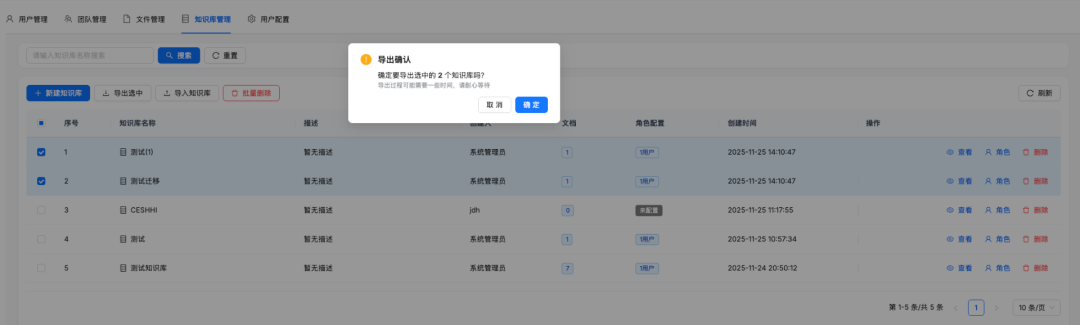

导出

二、导入功能

导入模式

1. 标准导入

适用场景:全新环境,知识库不存在

行为:创建新知识库,导入所有数据

冲突处理:若遇到同名知识库,则自动添加后缀(1)等

导入性能

基于实际测试数据:

注:导入时间主要取决于向量数据的导入速度,与网络和磁盘 I/O 性能相关。

三、技术架构

导出流程

# 伪代码展示导出逻辑

def export_knowledge_base(kb_id):

# 1. 收集元数据

metadata = collect_metadata(kb_id)

# 2. 导出文档

documents = export_documents(kb_id)

# 3. 导出分块(批量)

chunks = export_chunks_batch(kb_id, batch_size=1000)

# 4. 导出向量(压缩)

vectors = export_vectors_compressed(kb_id)

# 5. 导出图片和附件

assets = export_assets(kb_id)

# 6. 打包并压缩

package = create_zip_package(

metadata, documents, chunks, vectors, assets

)

# 7. 生成校验和

add_checksum(package)

return package

导入流程

# 伪代码展示导入逻辑

def import_knowledge_base(zip_file, mode='standard'):

# 1. 解压并验证

validate_package(zip_file)

# 2. 兼容性检查

check_compatibility()

# 3. 创建/更新知识库

kb = create_or_update_kb(mode)

# 4. 导入文档

import_documents(kb.id)

# 5. 导入分块(批量,事务)

with transaction():

import_chunks_batch(kb.id, batch_size=1000)

# 6. 导入向量(增量)

import_vectors_incremental(kb.id)

# 7. 重建索引

rebuild_elasticsearch_index(kb.id)

# 8. 验证数据完整性

verify_data_integrity(kb.id)

return kb

数据压缩策略

- • 分块文本:使用 JSONL 格式,gzip 压缩

- • 向量数据:使用 NumPy 的 savez_compressed,压缩率约 40%

典型压缩效果:

原始数据大小:500 MB

压缩后大小:180 MB

压缩比:36%

应用场景

场景一:金融行业的多环境部署

客户背景:某城商银行,需要在内外网分别部署知识库系统

传统痛点:

使用导入导出后的流程:

第一步:外网环境(测试)

↓

- 上传监管文件、制度文档 1000 份

- 使用 MinerU + PaddleOCR 全流程解析

- 调优分块参数,测试检索效果

- 处理时间:2 小时

↓

第二步:导出

↓

- 一键导出完整知识库

- 生成 export.knowflow.zip(约 300 MB)

- 导出时间:3 分钟

↓

第三步:物理介质传输

↓

- 使用加密 U 盘拷贝

- 通过网闸传输到内网

↓

第四步:内网环境(生产)

↓

- 上传 export.knowflow.zip

- 一键导入

- 导入时间:5 分钟

- 立即可用!

效果对比:

场景二:制造企业的车间知识库

客户背景:某汽车制造企业,需要在多个车间部署设备维修知识库

需求:

解决方案:

总部(云端):

- 处理 500 份设备文档

- 生成标准知识库

- 导出 1 份 knowflow.zip

↓

车间 1-10(边缘设备):

- 使用同一份 zip 包

- 并行导入到各车间系统

- 10 分钟内完成全部部署

商业价值:

场景三:AI 训练数据的版本管理

客户背景:某 AI 创业公司,需要管理不同版本的训练数据

使用场景:

v1.0 知识库(1 月版)

- 基础数据 10000 份文档

- 导出存档

↓

v2.0 知识库(3 月版)

- 新增数据 5000 份

- 优化分块策略

- 导出存档

↓

A/B 测试

- 环境 A 导入 v1.0

- 环境 B 导入 v2.0

- 对比检索效果

优势:

场景四:知识库的灾备与恢复

客户背景:某政务系统,合规要求定期备份

灾备方案:

灾难恢复演练:

T0: 主系统故障

T+2分钟: 启动备用系统

T+5分钟: 导入最新全量备份

T+8分钟: 导入增量备份

T+10分钟: 系统恢复服务

使用指南

快速开始

1. 导出知识库

Web 界面操作:

知识库管理页面

↓

选择目标知识库

↓

点击「导出」按钮

↓

点击「开始导出」

↓

等待打包

↓

下载 kb_xxx.zip 文件

API 调用:

curl -X POST "http://localhost:5000/api/v1/knowledge-base/export" \

-H "Authorization: Bearer YOUR_TOKEN" \

-H "Content-Type: application/json" \

-d '{

"kb_id": "your-kb-id",

"include_documents": true,

"include_chunks": true,

"include_vectors": true,

"include_images": false

}' \

--output kb_export.knowflow.zip

2. 导入知识库

Web 界面操作:

知识库管理页面

↓

点击「导入」按钮

↓

上传 .knowflow.zip 文件

↓

系统自动检查兼容性

↓

点击「开始导入」

↓

等待导入

↓

导入完成

API 调用:

curl -X POST "http://localhost:5000/api/v1/knowledge-base/import" \

-H "Authorization: Bearer YOUR_TOKEN" \

-F "file=@kb_export.knowflow.zip" \

-F "mode=standard"

最佳实践

1. 导出前的准备

2. 导入前的检查

3. 性能优化建议

大规模知识库导入优化:

# 临时调整 Elasticsearch 配置,提升导入速度

# 导入前执行

curl -X PUT "localhost:9200/_cluster/settings" -H 'Content-Type: application/json' -d'

{

"transient": {

"indices.memory.index_buffer_size": "30%",

"indices.memory.min_index_buffer_size": "96mb"

}

}'

# 导入完成后恢复默认配置

curl -X PUT "localhost:9200/_cluster/settings" -H 'Content-Type: application/json' -d'

{

"transient": {

"indices.memory.index_buffer_size": null,

"indices.memory.min_index_buffer_size": null

}

}'

4. 安全建议

技术细节

向量数据处理

挑战:向量数据通常占知识库总大小的 60-70%,如何高效传输?

解决方案:

# 导出时压缩

import numpy as np

vectors = load_vectors_from_db(kb_id)

np.savez_compressed('vectors.npz', vectors=vectors)

# 导入时增量加载

def import_vectors_incremental(npz_file, kb_id, batch_size=1000):

data = np.load(npz_file)

vectors = data['vectors']

for i in range(0, len(vectors), batch_size):

batch = vectors[i:i+batch_size]

insert_vectors_to_es(kb_id, batch)

update_progress(i / len(vectors))

压缩效果:

- • Float32 向量(1536 维):6 KB/条

Elasticsearch 索引迁移

索引映射导出:

{

"mappings": {

"properties": {

"content": {"type": "text", "analyzer": "ik_max_word"},

"content_vec": {"type": "dense_vector", "dims": 1536},

"doc_id": {"type": "keyword"},

"kb_id": {"type": "keyword"},

"create_time": {"type": "date"}

}

}

}

导入时自动创建索引:

数据一致性保障

事务性导入:

def import_with_transaction(kb_id, data):

try:

# 1. 开始事务

transaction = begin_transaction()

# 2. 导入数据库记录

import_db_records(kb_id, data, transaction)

# 3. 导入 ES 数据

import_es_data(kb_id, data)

# 4. 验证数据一致性

if not verify_consistency(kb_id):

raise Exception("Data inconsistency detected")

# 5. 提交事务

transaction.commit()

except Exception as e:

# 回滚所有操作

transaction.rollback()

cleanup_partial_import(kb_id)

raise e

未来规划

短期规划

集团总部(每月):

- 发布最新制度文件

- 统一解析和分块

- 导出标准知识库包

↓

子公司(自动):

- 接收导入包

- 一键增量导入

- 新制度立即生效

效果:

结语

知识库导入导出功能,看似只是一个"数据搬运"的能力,实则是 KnowFlow 对企业真实需求的深度洞察。

在 AI 时代,数据的流动性和可用性,与数据的安全性和合规性同等重要。

我们相信,通过打破在线与离线的边界,让强大的算力真正服务于每一个需要的场景,才能让 AI 技术真正落地于企业的核心业务流程。

KnowFlow v2.1.9,期待与您一起探索知识管理的更多可能!