推荐语

AI测试平台如何突破技术与人机协同的双重挑战?探索AI在软件测试中的落地实践与解决方案。

核心内容:

1. AI重塑软件测试的转型趋势与机遇

2. 应对AI模型局限性与系统集成的三大策略

3. 人机协同设计的关键挑战与平衡之道

杨芳贤

53AI创始人/腾讯云(TVP)最具价值专家

AI Test:AI 测试平台落地实践

一、AI 正在重塑软件测试领域

人工智能正在深度改变各行各业,软件测试也不例外。随着 AI 在自然语言理解、图像识别、意图规划等方面的成熟发展,测试方法正在从 “人 + 代码驱动的传统测试” 向 “AI 驱动的智能测试” 转型。

AI 的出现,使构建低门槛、高覆盖、强适应性的测试体系成为可能。

AITest 项目的提出,正是为了探索如何解决测试领域长期存在的难题。

二、AI 落地的现实挑战

1. AI 模型的固有局限

- 幻觉问题:模型可能输出看似合理却错误或编造的信息,在高精度场景中尤为致命。

- 不确定性:LLM(大型语言模型)是概率生成模型,决策过程不透明,输出难以解释且结果不稳定。

- 性能问题:大模型存在响应速度慢、吞吐能力有限的问题(多模态更严峻),在低延迟、高并发的场景中很难满足要求。

2. 与系统/工作流的集成挑战

系统集成误区

误区一:AI = 聊天机器人

简单地把 AI 理解为交互方式的变化,只关注对话体验,而忽视了 AI 在决策、规划、自动化上的潜力,人为限制了 AI 的价值发挥。

误区二:AI 能力 = 产品能力

把 AI 的生成能力直接当作产品能力,而忽视了完整的 产品化、工程化过程。这样做出来的往往只是一个 demo,不具备生产可用性。

误区三:直接接入大模型 = 平台智能化

低估工程化的投入。要使 LLM 具备业务理解力、稳定性和可控性,需要大量“辅助工程”,包括数据预处理、模型微调、知识图谱、反馈机制等。

系统集成思路

明确现有工作流

- 梳理清楚现有系统的工作流,明确人、程序各自负责的节点,识别确实存在的痛点。

- 探讨可行的技术方案,评估 AI 接入是否真正能解决问题。

识别切入点

- 哪些环节可以引入 AI?例如需求理解、环境搭建、用例调试、报告分析。

- AI 能解决哪些痛点?主要聚焦于意图理解、模式识别、信息提取与生成等任务。

集成策略设计

- 执行闭环如何建立?如何通过反馈机制让 AI 持续改进?

- 如何保证 AI 系统具备环境感知和自我调整的能力?

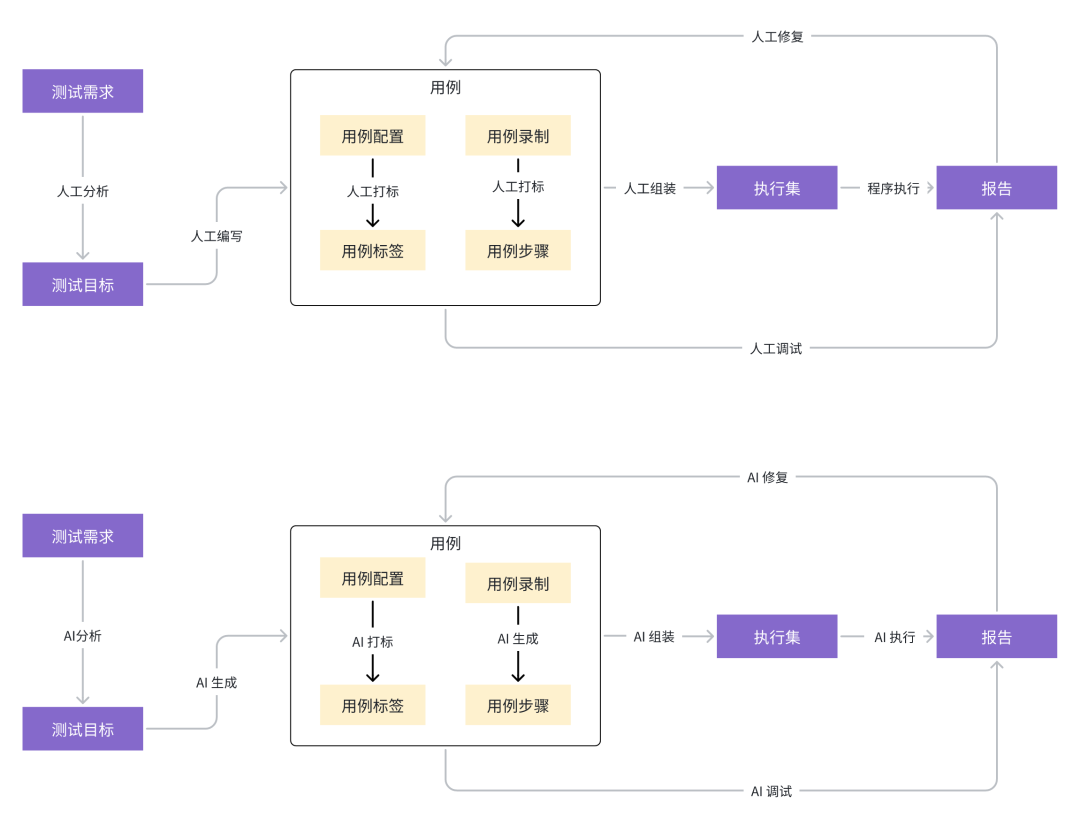

AITest 工作流

3. 与人的集成挑战

AI 的落地不仅是技术问题,也涉及人机关系的再设计。

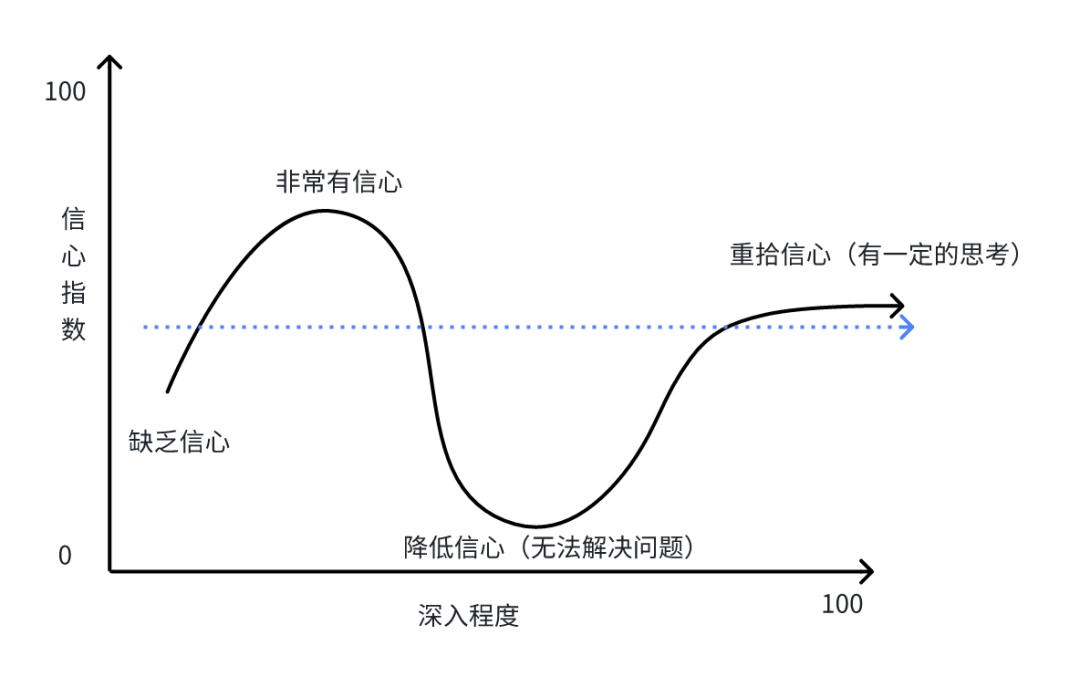

AI 信心指数

- 一次小失误,就可能大幅削弱他们的信任,破坏其高效工作流。

人机协同困境

- 难以判断 干预时机、修改方式、对 AI 的合理预期。

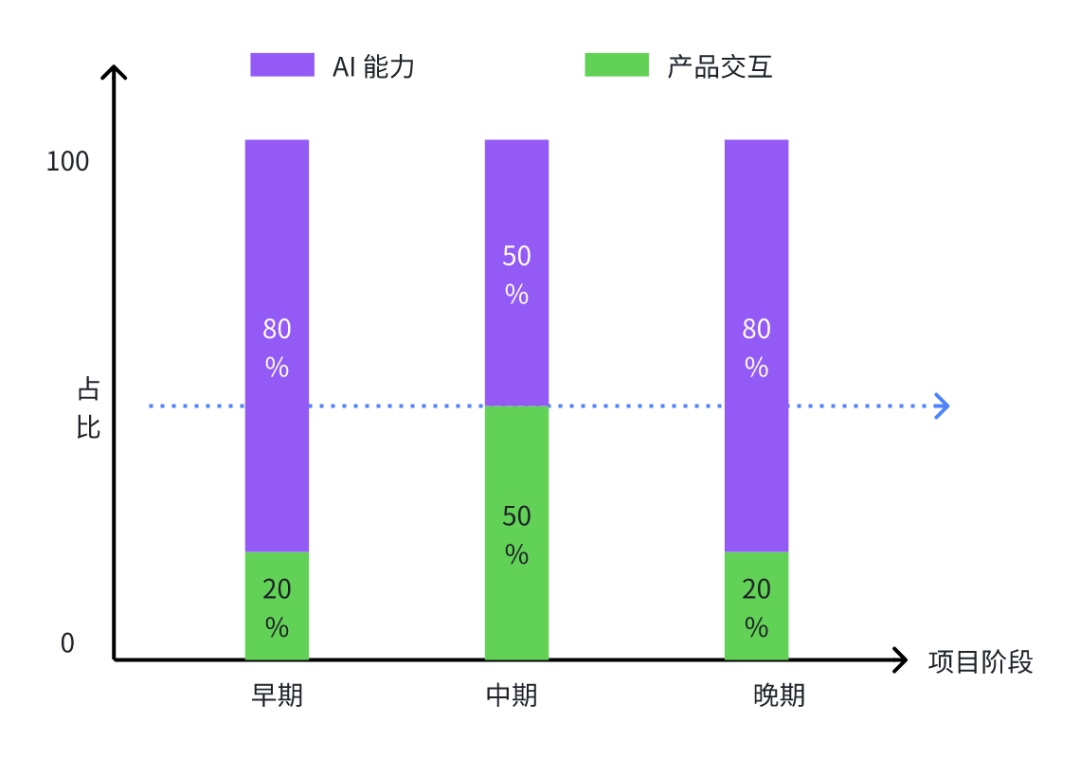

4. 产品交互与 AI 效果的优先级

在 AI 项目中,产品交互的价值常被讨论,有两种观点:

交互重要派

- 好的产品交互是兜底手段,在 AI 出现不确定性时,引导用户修正;

交互不重要派

- 如果 AI 效果不好,再好的交互也无济于事,无法真正解决用户目标。

实践建议

- 早期项目:优先打磨 AI 核心能力,确保核心流程跑通。

- 中期项目:完善交互作为兜底,优化流程,保证最基础的用户体验。

👉 总结:好的交互体验是必要条件,但真正的优先级应当给到 AI 核心能力。

三、AI 驱动测试的理想与现实

- 理想愿景:完全自动化测试 —— AI 能够独立理解需求、生成用例、执行验证,甚至自动修复。

- 现实状态:目前的 AI 还难以独立承担复杂逻辑处理、数据初始化、状态追踪等任务。

因此,在相当长的一段时间内,AI 测试必然处于 “AI + 人” 协同模式。

人机协同,是当前价值最大化的可行路径。

换句话说,AI 测试的未来方向很明确:走向完全自动化。但在能力尚未成熟之前,我们必须接受一个“AI + 人”共存的过渡阶段。

什么时候能实现理想愿景?要么依赖大模型能力的重大突破,要么通过更强的工程化手段解决幻觉、不确定性、性能等问题。

👉 所以,完全自动化是目标,但人机协同才是当下的现实与必经之路。

四、AITest 的项目经验

1. 核心经验总结

经验一:模型 ≠ 系统

模型只是具备单一能力的 Agent,应专注于特定任务。凡是可以由传统程序解决的,不必交给模型。

- 人始终保持最终控制权,并通过反馈机制修正 AI 的结果。

经验三:AI Native ≠ 颠覆产品形态

AI 的价值在于增强功能、优化工作流,而不是推翻既有产品形态。

解决痛点 > 炫技式重构,这是更现实的落地路径。

2. 实践要点

模型定位与预期管理

- 明确 LLM 的核心价值(意图理解、模式识别、原因分析等),不要期待它成为万能解法;

- 避免过度依赖,把 AI 视为“辅助工具”更符合当前能力。

人机职责划分与协作

- 清晰定义边界:AI 负责用例生成、初步分析;人负责审核、决策、确认;

- 设计便捷的人机交互界面,让用户能随时修改 AI 结果并提供反馈。

工作流程闭环

- 数据驱动:沉淀 AI 生成结果、执行数据、缺陷与反馈;

- 效果评估:设定指标(用例生成效率、缺陷发现率、误报率、修正成本);

- 持续迭代:定期优化 Prompt、模型与知识库,保证系统长期演进。

五、AI × 程序的协同设计

1. AI 与程序的角色

AI 的角色

- 负责理解、规划与探索,这些任务是传统程序难以胜任的;

- 在这些场景中,AI 扮演了“人的能力”,能够处理模糊、非结构化信息。

程序的角色

- 在绝大多数标准化、重复性的任务中表现稳定可靠,效率高于 AI。

协同原则

在设计 AI 产品或 AI 驱动的测试系统时,应充分利用两者的互补优势:

2. AITest 实践示例:用例执行

- 对程序执行失败或边界异常的用例进行补充执行,提升整体稳定性。

- 形成 AI + 程序的闭环协同,持续提升测试质量与效率。

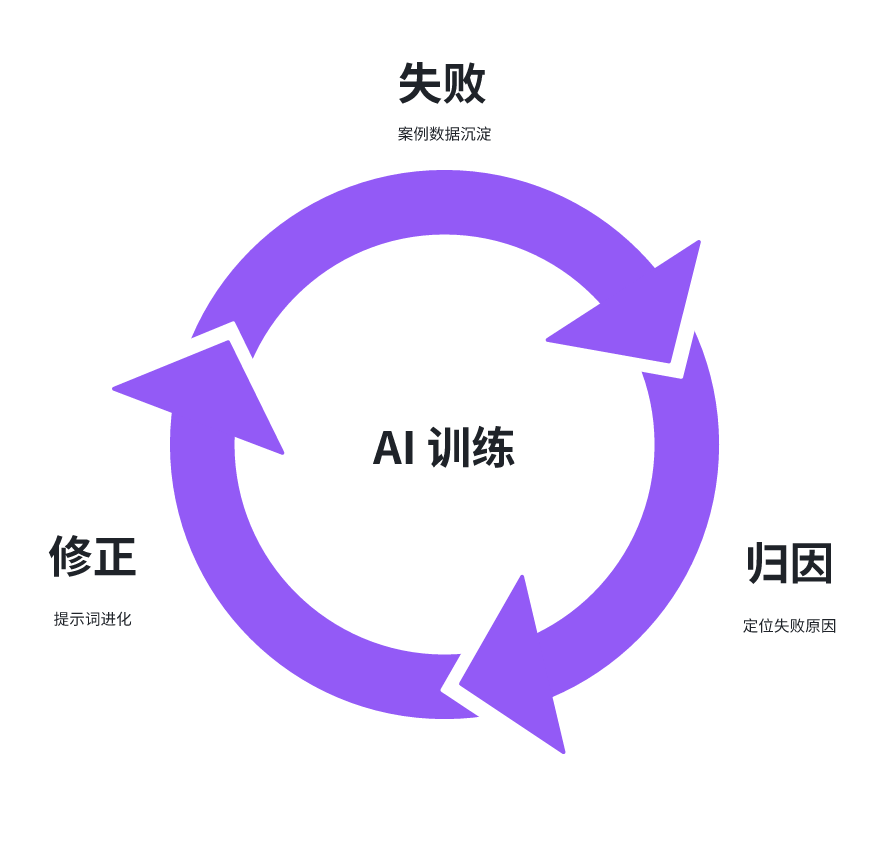

六、反馈与优化的重要性

AI 的输出天然存在不确定性,因此失败是优化的前提。在 AI 项目中,反馈与优化是持续提升系统能力、实现可控性的核心机制。

闭环优化的核心目标

让 AI “记住教训”、形成偏好、学习更优策略,构建可追踪、可学习、可演进的系统能力。

关键步骤

- 通过量化效果评估优化策略,确保 AI 输出可控和可预测。

📌 核心理念

反馈与优化不是一次性的修复动作,而是系统性能力的建设。

持续沉淀数据、迭代优化提示、量化效果,形成闭环,让 AI 在实践中不断进化.

七、未来展望

AI 在软件测试中的演进将分为三个阶段:

结束语

AI 在测试领域的应用,核心在于 工程化思维 + 人机协同模式。

通过合理的模型定位、清晰的职责划分、完善的反馈机制,AI 才能逐步从辅助走向驱动,最终实现自主化测试。

AITest 项目的实践表明:AI × 程序 × 人 的协同,是推动测试智能化的最佳路径。